Deepseek-R1 est un modèle ouvert avec des capacités de raisonnement de pointe. Au lieu d’offrir des réponses directes, des modèles de raisonnement comme Deepseek-R1 effectuent plusieurs passes d’inférence sur une requête, effectuant des méthodes de chaîne de réflexion, de consensus et de recherche pour générer la meilleure réponse.

La réalisation de cette séquence de passes d’inférence – en utilisant la raison pour arriver à la meilleure réponse – est connue sous le nom de mise à l’échelle du temps de test. Deepseek-R1 est un exemple parfait de cette loi d’échelle, démontrant pourquoi l’informatique accélérée est essentielle pour les exigences de l’inférence de l’IA agentique.

Comme les modèles sont autorisés à «penser» itérativement à travers le problème, ils créent plus de jetons de sortie et des cycles de génération plus longs, de sorte que la qualité du modèle continue de se développer. Un calcul significatif en temps de test est essentiel pour permettre à la fois une inférence en temps réel et des réponses de meilleure qualité à partir de modèles de raisonnement comme Deepseek-R1, nécessitant des déploiements d’inférence plus importants.

R1 offre une précision principale pour les tâches exigeant l’inférence logique, le raisonnement, les mathématiques, le codage et la compréhension du langage tout en offrant une efficacité d’inférence élevée.

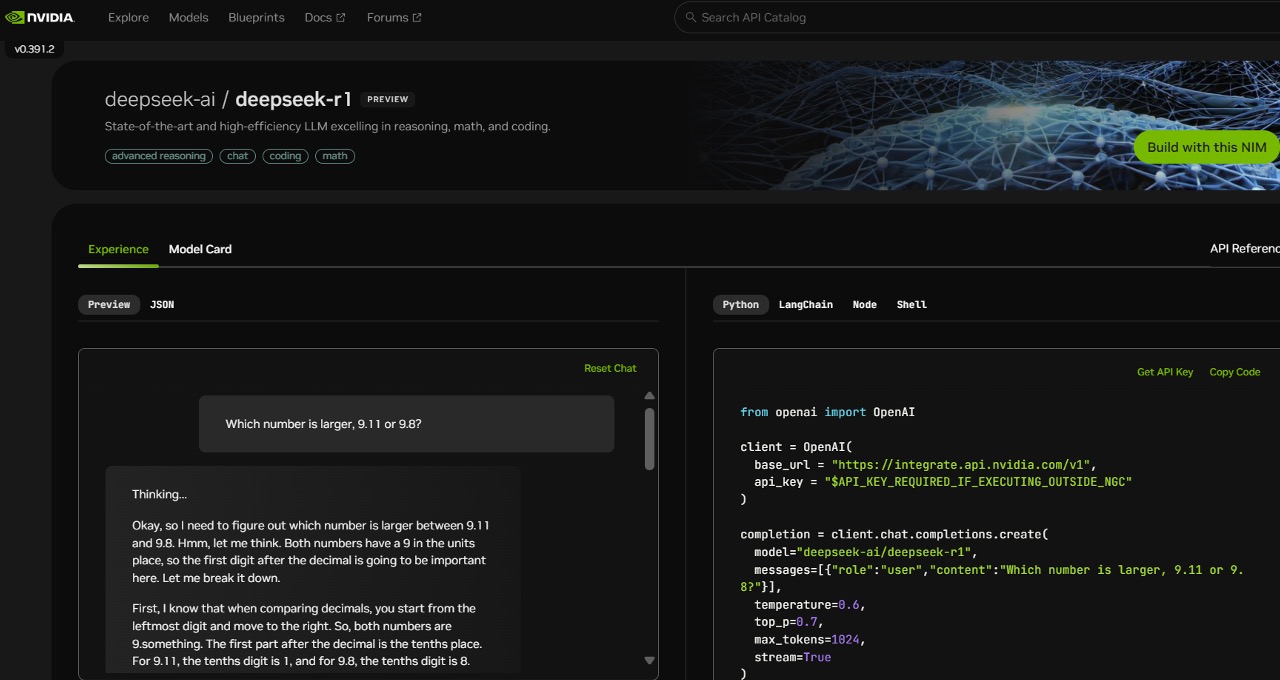

Pour aider les développeurs à expérimenter en toute sécurité ces capacités et à construire leurs propres agents spécialisés, le modèle Deepseek-R1 de 671 milliards de dollars est désormais disponible en prévisualisation de microservice NVIDIA NIM sur build.nvidia.com. Le microservice NIM Deepseek-R1 peut fournir jusqu’à 3 872 jetons par seconde sur un seul système NVIDIA HGX H200.

Les développeurs peuvent tester et expérimenter l’interface de programmation d’applications (API), qui devrait être disponible dès un microservice NIM téléchargeable, qui fait partie de la plate-forme logicielle NVIDIA AI Enterprise.

Le microservice NIM Deepseek-R1 simplifie les déploiements avec le soutien aux API standard de l’industrie. Les entreprises peuvent maximiser la sécurité et la confidentialité des données en exécutant le microservice NIM sur leur infrastructure informatique accélérée préférée. En utilisant la fonderie NVIDIA AI avec le logiciel NVIDIA NEMO, les entreprises pourront également créer des microservices NIM Deepseek-R1 personnalisés pour des agents d’IA spécialisés.

Deepseek-R1 – un parfait exemple de mise à l’échelle du temps de test

Deepseek-R1 est un grand modèle de mélange d’Experts (MOE). Il intègre 671 milliards de paramètres impressionnants – 10x de plus que de nombreux autres LLMs d’Open-source populaires – prenant en charge une grande durée de contexte d’entrée de 128 000 jetons. Le modèle utilise également un nombre extrême d’experts par couche. Chaque couche de R1 compte 256 experts, chaque jeton acheminé vers huit experts distincts en parallèle pour l’évaluation.

La livraison de réponses en temps réel pour R1 nécessite de nombreux GPU avec des performances de calcul élevées, liées à une communication à large bande passante et à faible latence pour acheminer les jetons rapides à tous les experts pour l’inférence. Combiné avec les optimisations de logiciels disponibles dans le NVIDIA NIM Microservice, un seul serveur avec huit GPU H200 connectés à l’aide de NvLink et NVLink Switch peut exécuter le modèle complet de 671 milliards de paramètres Deepseek-R1 jusqu’à 3872 jetons par seconde. Ce débit est rendu possible en utilisant le moteur FP8 du transformateur FP8 de l’architecture Nvidia Hopper à chaque couche – et les 900 Go / s de la bande passante NVLink pour la communication d’experts MOE.

Il est essentiel d’obtenir chaque opération de point flottante par seconde (flops) de performances d’un GPU pour l’inférence en temps réel. L’architecture NVIDIA Blackwell de nouvelle génération donnera à une mise à l’échelle du temps de test sur des modèles de raisonnement comme Deepseek-R1 un coup de pouce géant avec des noyaux de tenseur de cinquième génération qui peuvent fournir jusqu’à 20 Petaflops de performances de calcul FP4 de pointe et un domaine NVLink 72-gpu spécifiquement optimisé spécifiquement optimisé spécifique pour l’inférence.

Commencez maintenant avec le Microservice Nim Deepseek-R1

Les développeurs peuvent découvrir le Microservice Nim Deepseek-R1, désormais disponible sur build.nvidia.com. Regardez comment cela fonctionne:

https://www.youtube.com/watch?v=47dwcezg1cg

Avec NVIDIA NIM, les entreprises peuvent déployer facilement Deepseek-R1 et s’assurer qu’elles obtiennent la grande efficacité nécessaire pour les systèmes d’IA agentiques.

Voir avis concernant les informations sur les produits logiciels.